芯动力RPP-R8芯片与Llama2大模型系统的适配:边缘计算的新里程碑

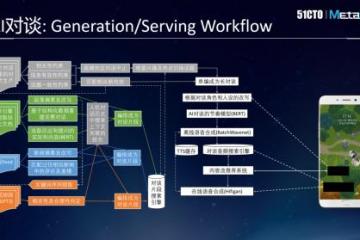

在当今的人工智能领域,大模型系统已经成为了一个重要的研究方向。近期,Meta推出的Llama2模型以其强大的语言模型联想能力、大模型背景以及中英文字节化、循环输入等特性,受到了广泛的关注。随着AI大模型的发展,边缘计算将越来越普及,而可大可“小”的Llama2模型的诞生更是促进了边缘计算的应用落地,同时也带来了新兴行业商业机会。然而,将这些强大的大模型系统成功地部署到边缘设备上,依然是一个极富挑战性的问题。 Llama2模型系统:AI领域新纪元 Llama 2的诞生标志着大模型系统在人工智能领域的应用进入了新的阶段。相比Llama 1,Llama 2的模型大小更大,训练数据更多,上下文长度也更长。这些特点使得Llama 2在推理、编码、熟练程度和知识测试等方面都表现出色,超越了许多其他开源语言模型。 然而,将这样的大模型系统部署到边缘设备上并不是一件容易的事情。边缘设备的计算能力和存储能力有限,无法支持大型模型的运行。因此,如何在大模型和边缘设备之间找到一个平衡点成为了亟待解决的问题。 芯动力RPP-R8芯片Llama2大模型适配成功 在此背景下,芯动力尝试使用RPP-R8芯片与Llama 2大模型进行适配,并且已经取得成功。RPP-R8芯片作为一款应用在边缘端的高性能、低功耗的AI芯片,为Llama2模型系统提供了强大的计算支撑。该芯片采用先进的制程工艺和架构设计,具备高性能、低延迟的特点,能够满足Llama2模型系统对计算能力的极高要求。同时,芯动力RPP-R8芯片还具有优秀的能效比,有效解决了模型系统运行过程中的散热问题,保证了系统的稳定性和可靠性。 适配原理及优势 芯动力RPP-R8芯片与Llama2模型系统的适配原理主要体现在以下几个方面: 硬件层面 RPP-R8芯片在能耗控制上非常出色。在使用70亿模型时,其浮点运算的内存大小为14GB,整数运算的内存大小为7GB,而小数运算的内存大小为3.5GB。这样的内存使用效率使得RPP-R8芯片在处理大规模模型时仍能保持低功耗。并且,RPP-R8芯片的运行速度也非常快,这与芯片的内存带宽有着直接的关系,内存带宽越大,运行速度就越快。此外,RPP-R8芯片还采用了先进的封装技术,减小了芯片尺寸和功耗,提高了集成度和灵活性。 软件层面 芯动力RPP-R8芯片从指令级开始逐层向上兼容CUDA;这意味着使用CUDA编写的程序可以直接在RPP-R8芯片上运行,无需进行任何修改。这大大提高了程序的开发效率,也使得CUDA用户可以无缝地迁移到RPP-R8芯片上。此外,该芯片还支持多种主流深度学习框架,如TensorFlow、PyTorch等,方便开发者在平台上进行算法优化和程序编写。针对Llama2模型系统的特殊优化进一步提高了模型运行效率。 应用层面 芯动力RPP-R8芯片凭借其优秀的能效比为Llama2模型系统提供了出色的边缘计算能力。在移动设备等应用场景中,该芯片可以充分发挥其优势,提高用户体验。 芯动力RPP-R8芯片与Llama2大模型系统的适配为大模型系统在边缘设备上的部署提供了新的可能。它的高效能耗控制和强大的计算能力使得大模型系统可以在边缘设备上进行高效的运行,也为边缘计算的应用落地提供了新的可能性。随着AI技术的不断发展,我们相信未来会有更多的创新技术涌现出来,推动人工智能领域的发展不断向前迈进。 |