AI服务器及服务器散热器行业发展浅析

AI服务器是一种专为人工智能应用设计的高性能计算设备,其核心特征在于异构硬件架构与软硬件协同优化。与传统服务器相比,AI服务器通过集成GPU、TPU、FPGA等加速芯片,提供强大的并行计算能力,以高效处理深度学习、自然语言处理等任务所需的海量数据和复杂算法。同时,它配备大容量高带宽内存(如HBM)、高速存储(如NVMe SSD)及低延迟网络(如InfiniBand),确保数据快速传输与实时处理。软件层面则预装TensorFlow、PyTorch等AI框架及优化库,实现算法高效执行。这些特性使AI服务器成为支撑模型训练与推理的关键基础设施,广泛应用于自动驾驶、医疗诊断、智能语音识别等领域。

数据中心是集中部署服务器、存储设备和网络设施等硬件资源的现代化信息处理枢纽,其核心功能在于高效管理海量数据的存储、计算与传输,为数字社会提供底层算力支撑。作为互联网的“中枢大脑”,它通过集成供电、散热、安防等支持系统,确保信息服务的持续稳定运行,使在线支付、远程医疗、自动驾驶等应用得以实现。在数字经济时代,数据中心已从传统业务辅助角色升级为核心生产系统,不仅支撑企业运营与创新转型,更通过云计算、人工智能等技术赋能千行百业,成为推动社会信息化、智能化发展的关键基础设施。其战略意义堪比电力系统与交通网络,既是经济增长的新引擎,也是保障数据主权与数字安全的基石。数据中心是AI服务器部署的物理载体,为其提供算力支撑、能源保障及网络环境,而AI服务器作为数据中心的核心引擎,通过异构计算架构(如GPU/ASIC)驱动海量数据处理与模型训练,实现数据中心从通用计算向智能计算的转型升级。

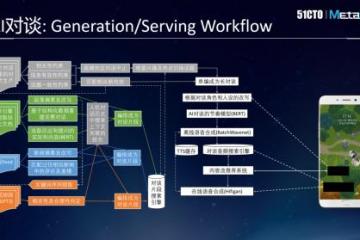

近年来,随着数据中心处理的核心负载逐渐从通用型任务转向海量非结构化数据处理与复杂模型实时推理,其底层基础设施正经历面向AI的深度重构。这种转型需求直接驱动了AI服务器作为新一代算力核心的崛起,其特征是高度专业化设计以应对前所未有的计算密集性与效率挑战。全球范围内,这一新兴领域正经历深刻的结构性变革:北美云服务巨头(微软、Meta、AWS)凭借巨大资本投入主导数据中心向液冷散热与高密度部署升级,以支撑万亿参数级大模型的训练需求;同时,推理服务器需求的爆发性增长推动市场重心转移,边缘计算场景(如自动驾驶的毫秒级决策、金融高频交易的实时风控)成为核心增长引擎。供应链层面,英伟达GPU与ASIC芯片构建了当前的算力基础,但高端组件良率问题加剧了供应约束,而大型厂商的订单积压凸显了电力与冷却等配套基础设施的发展瓶颈。为突破外部依赖,科技企业加速垂直整合战略,Meta推进自研ASIC芯片以优化架构,AWS通过定制芯片深度整合软硬件以形成闭环生态。新兴区域也积极布局,欧洲借政策导向吸引全球企业在本地建设AI节点,非洲等地的初创公司则探索将边缘AI服务器融入农业预测与基层医疗。展望未来,随着数字孪生、生物医药模拟等新兴场景的拓展,AI服务器的架构正从集中式云端向更适应分布式需求的“云-边-端”融合范式加速演进,推理服务平台也成为全球化服务的关键载体。

中国AI服务器产业在政策强力驱动与市场需求激增的双重催化下蓬勃发展,技术创新成为核心引擎:通过异构计算架构(如CPU+GPU/ASIC融合)显著提升算力密度,液冷散热技术广泛应用以优化能效,同时国产芯片(如华为昇腾)加速替代进口方案,推动软硬件生态自主化。市场格局由浪潮信息、华为等头部厂商主导,新兴企业则聚焦边缘计算等定制化场景崛起,应用领域从互联网、金融风控快速扩展至智能制造、智慧城市及医疗诊断等多元化场景。尽管面临核心技术依赖与国际生态壁垒等挑战,行业正积极向推理型服务器和分布式边缘计算转型,支撑AI基础设施向智能化、高效化持续演进。受益于人工智能和算力市场发展的推动,中国AI服务器市场规模实现了逐年增长。

AI高速服务器用散热器系专为应对高功率密度人工智能芯片(如GPU/TPU)及整机柜高热负荷场景所设计的关键热管理解决方案。针对传统风冷难以消解的极端散热瓶颈,其通过三重技术路径实现突破,风冷优化方案利用均热板与高气流效率风扇提升基础散热能力;液冷主导技术涵盖冷板式直触导热与浸没式全域冷却双模式;相变冷却系统则依托液态金属与氟化液相变循环机制突破千瓦级单芯片散热极限。在创新层面,其深度融合三维堆叠微通道结构以降低热阻,嵌入智能温控算法实现动态能耗调控,并整合石墨烯复合材料达成轻量化高导热特性。此外,其模块化架构设计进一步确保散热系统与芯片制程迭代的同步演进,最终构建起保障高算力硬件持续稳定运行的核心热管理支撑体系。

AI高速服务器用散热器至关重要,它确保了服务器在超强算力负载下核心部件(如CPU和GPU)的稳定运行。高效的散热(尤其是液冷技术)能将产生的巨大热量迅速排出,防止芯片因过热而降频或停机,从而保障模型训练和推理任务所需的持续峰值性能输出。同时,精准的散热控制有效避免了高温环境对电子元器件的加速老化和潜在损害,大幅提升了硬件的可靠性和使用寿命,减少了因硬件故障导致的数据丢失或服务中断风险。此外,相较于传统散热方式,现代高效散热器显著降低了为散热本身所需的庞大能耗,并减少了对机房物理空间的需求,为构建更绿色、更具成本效益和可扩展性的AI计算基础设施奠定了坚实的基础。

随着生成式AI推动算力需求爆发式增长,AI服务器芯片热设计功耗持续攀升,传统风冷方案已逼近物理极限,驱动散热技术向高效能方向快速迭代。当前,AI高速服务器用散热器发展呈现三大核心特征,在技术路线演进方面,主流方案从气冷优化(均热板+高气流风扇)转向液冷主导,冷板式液冷因直接接触芯片导热成为超算中心标配,浸没式液冷则通过全域冷却突破空间限制,更高阶的相变冷却(液态金属/氟化液相变循环)开始突破单芯片千瓦级散热瓶颈。在创新集成深化方面,三维堆叠微通道设计显著降低热阻,石墨烯复合材料实现轻量化与高导热协同,智能温控算法动态优化能耗,模块化架构支持热插拔升级,为3nm及以下芯片技术预留兼容空间。在产业价值重构方面,散热器从辅助组件升级为服务器核心子系统,单芯片散热价值量大幅提升。国际头部厂商主导高端市场,但国产化进程加速,本土企业通过航天级热管技术转化、液冷方案定制等路径切入产业链,逐步构建自主技术体系。整体而言,AI散热器正从单一硬件向“材料-结构-算法”集成系统演进,其技术成熟度与产业协同能力已成为制约算力释放的关键支点。

受益于生成式AI的发展推高算力需求,我国AI高速服务器用散热器需求日益增长,逐渐成为中国散热器市场重要的增长极,2022-2024年其在中国散热器市场份额占比约为5.87%。未来,随着大模型训练与推理任务复杂度飙升,AI服务器集群的功耗密度大幅攀升,单芯片热功耗突破传统散热极限,将加快推动散热方案从传统风冷向高效液冷升级;同时,国家“十四五”规划及“东数西算”工程强化绿色计算政策,要求数据中心降低PUE值,液冷技术因显著节能优势成为首选;此外,本土企业加快突破液冷关键技术(如智能温控、微歧管射流),加速商业化落地,叠加互联网、电信等行业对液冷服务器的采购需求激增,共同驱动市场扩容。